大家好,我是毛毛。

今天是Day 16

今天看的是penalty的部分~ ヽ(✿゚▽゚)ノ

這篇是2018年七月刊登在Trans. Emerg. Telecommun. Technol.上的論文。

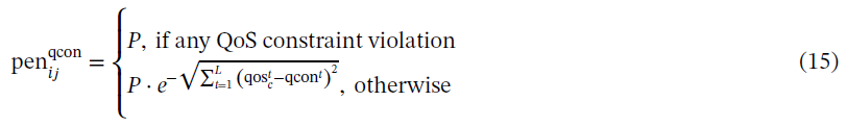

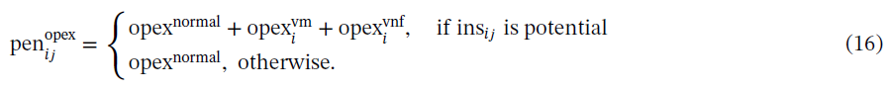

在傳統的強化學習模型,並沒有明確地指定限制,所以如果我們採用標準強化學習,並將QoE作為獎勵,這樣並不會有QoS的限制,因此要讓強化學習的Reward滿足QoE和QoS的方法就是加上QoS的限制。

一條SFC chain c的immediate Reward如下

對於那些參與建構chain c的VNF,chain c的reward均勻分佈在它們之間,公式如下

因為QoE要大,需要的資源就要多;而滿足QoS的限制,花費的資源就要小於該限制,代表花的資源相對要減少,所以透過上面它設計的Reward讓強化學習的效果能滿足QoE又不違背QoS的限制。

明天在看Deep Q-network的東西啦~

大家明天見![]()